Différences entre les versions de « Big Data »

m (→Définition) |

m (→Applications) |

||

| (5 versions intermédiaires par le même utilisateur non affichées) | |||

| Ligne 1 : | Ligne 1 : | ||

{| class="wikitable" | {| class="wikitable" | ||

|←[[ | |←[[Modéliser]] | ||

|[[Management des Connaissances Organisationnelles - Elements de Cours|⌂ retour]] | |[[Management des Connaissances Organisationnelles - Elements de Cours|⌂ retour]] | ||

|[[ | |[[Accès à l'information]] → | ||

|} | |} | ||

== Définition == | == Définition == | ||

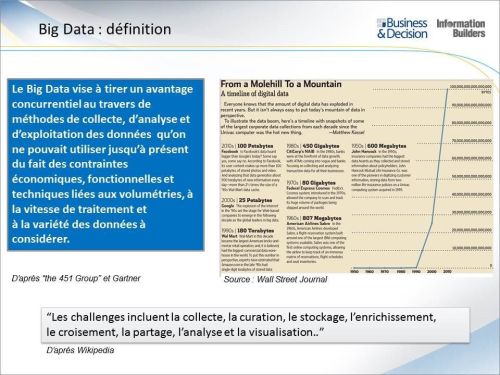

''"On parle depuis quelques années du phénomène de big data , que l’on traduit souvent par « données massives ». Avec le développement des nouvelles technologies, d’internet et des réseaux sociaux ces vingt dernières années, la production de données numériques a été de plus en plus nombreuse : textes, photos, vidéos, etc. Le gigantesque volume de données numériques produites combiné aux capacités sans cesse accrues de stockage et à des outils d’analyse en temps réel de plus en plus sophistiqués offre aujourd’hui des possibilités inégalées d’exploitation des informations. Les ensembles de données traités correspondant à la définition du big data répondent à trois caractéristiques principales : volume, vélocité et variété."''<ref>https://www.cnil.fr/fr/definition/big-data</ref> | ''"On parle depuis quelques années du phénomène de big data , que l’on traduit souvent par « données massives ». Avec le développement des nouvelles technologies, d’internet et des réseaux sociaux ces vingt dernières années, la production de données numériques a été de plus en plus nombreuse : textes, photos, vidéos, etc. Le gigantesque volume de données numériques produites combiné aux capacités sans cesse accrues de stockage et à des outils d’analyse en temps réel de plus en plus sophistiqués offre aujourd’hui des possibilités inégalées d’exploitation des informations. Les ensembles de données traités correspondant à la définition du big data répondent à trois caractéristiques principales : volume, vélocité et variété."''<ref>https://www.cnil.fr/fr/definition/big-data</ref> | ||

[[Fichier:Information-builders-mdm-bigdata-131016140315-phpapp01.jpg|alt=Big Data : Définition|centré|vignette|500x500px|Big Data : Définition<ref>https://visionarymarketing.com/fr/2013/10/big-data-exemples/</ref>]] | [[Fichier:Information-builders-mdm-bigdata-131016140315-phpapp01.jpg|alt=Big Data : Définition|centré|vignette|500x500px|Big Data : Définition<ref>https://visionarymarketing.com/fr/2013/10/big-data-exemples/</ref>]] | ||

== Les V == | == Les V == | ||

Le terme "Big Data" fait référence à des ensembles de données extrêmement volumineux, complexes et variables qui dépassent souvent la capacité des systèmes informatiques traditionnels à les gérer et à les analyser efficacement. '''Le Big Data est caractérisé par les "trois V" suivants ''': | |||

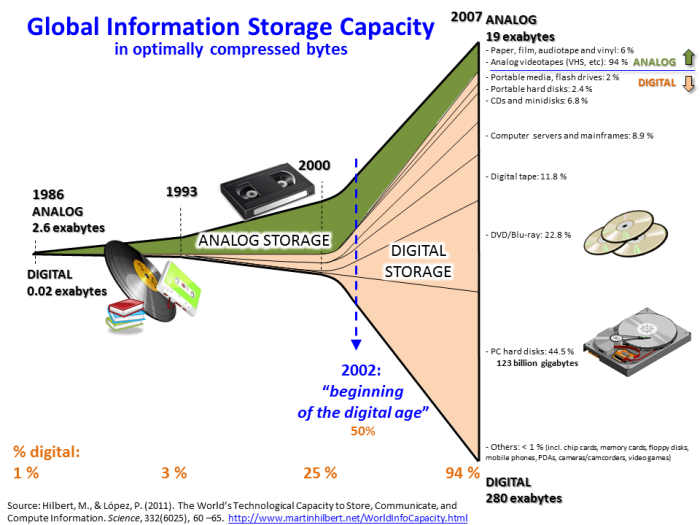

* | * '''Volume''' : Le Big Data implique des quantités massives de données. Ces données peuvent provenir de diverses sources telles que les transactions commerciales, les réseaux sociaux, les capteurs, les dispositifs IoT (Internet des objets), les données générées par les utilisateurs, etc. La taille des ensembles de données est souvent mesurée en téraoctets, pétaoctets, voire exaoctets. | ||

* | * '''Variété''' : Le Big Data peut prendre différentes formes, notamment des données structurées, semi-structurées et non structurées. Les données structurées sont organisées de manière tabulaire (par exemple, bases de données relationnelles), les données semi-structurées ont une certaine structure mais ne rentrent pas parfaitement dans des tables (par exemple, JSON, XML), tandis que les données non structurées, comme les vidéos, les images, les textes libres, ne suivent généralement aucune structure prédéfinie. | ||

* | * '''Vélocité''' : Le Big Data est généré à des vitesses élevées. Les données peuvent être créées en temps réel ou à un rythme très rapide, comme dans le cas des flux de données en continu. La capacité à traiter et à analyser ces données en temps réel est souvent cruciale dans un environnement Big Data. | ||

Au fil du temps, d'autres caractéristiques ont été ajoutées pour décrire le Big Data, telles que la '''variabilité''' (la capacité à gérer des données dont les caractéristiques changent avec le temps) et la '''véracité''' (la qualité des données et la confiance dans leur précision). | |||

'''Pour traiter et tirer des informations significatives de ces ensembles de données massifs, de nouvelles technologies et méthodologies ont émergé, notamment le traitement parallèle, le stockage distribué, les bases de données NoSQL, les technologies de traitement en temps réel, l'apprentissage automatique, etc.''' Le Big Data est utilisé dans une variété de secteurs, y compris le commerce, la santé, la finance, les sciences, la recherche, et bien d'autres, pour prendre des décisions éclairées, découvrir des tendances et optimiser les opérations. | |||

https://infonet.fr/lexique/definitions/big-data/ | |||

* la '''vélocité''' : la grande rapidité à laquelle les données sont créées, stockées et analysées | |||

* le '''volume''' : il n’y a pas de fin, le nombre de données ne cesse de croître | |||

* la '''variété''' : elles peuvent provenir de différentes sources et se présenter sous différentes formes | |||

[[Fichier:Hilbert InfoGrowth.png|alt=Hilbert InfoGrowth|centré|vignette|700x700px|Hilbert InfoGrowth<ref>Hilbert, M., & López, P. (2011). The world’s technological capacity to store, communicate, and compute information. ''science'', ''332''(6025), 60-65.</ref>]] | [[Fichier:Hilbert InfoGrowth.png|alt=Hilbert InfoGrowth|centré|vignette|700x700px|Hilbert InfoGrowth<ref>Hilbert, M., & López, P. (2011). The world’s technological capacity to store, communicate, and compute information. ''science'', ''332''(6025), 60-65.</ref>]] | ||

== Infrastructure == | == Infrastructure == | ||

Les infrastructures Big Data sont constituées de technologies matérielles, logicielles et réseau conçues pour gérer, stocker, traiter et analyser des ensembles de données massives et complexes. Ces infrastructures sont essentielles pour tirer parti des avantages du Big Data en fournissant la puissance de calcul et les ressources nécessaires pour manipuler d'énormes volumes de données. Voici quelques '''composants clés des infrastructures Big Data''' : | |||

* '''Stockage Distribué''' : Les systèmes de stockage distribué sont utilisés pour stocker des volumes massifs de données sur plusieurs nœuds ou serveurs. Hadoop Distributed File System (HDFS) est un exemple courant de système de stockage distribué dans l'écosystème Hadoop. | |||

* '''Traitement Distribué''' : Les frameworks de traitement distribué permettent de traiter des données à grande échelle en parallèle sur un cluster de serveurs. Apache Hadoop MapReduce est un exemple classique de framework de traitement distribué, mais d'autres, comme Apache Spark, sont également largement utilisés. | |||

* '''Systèmes de Gestion de Base de Données NoSQ'''L : Les bases de données NoSQL, telles que MongoDB, Cassandra, et Couchbase, sont utilisées pour gérer des données non structurées ou semi-structurées, offrant une flexibilité supérieure à celle des bases de données relationnelles traditionnelles. | |||

* '''Systèmes de Gestion de Flux de Données''' : Les infrastructures Big Data doivent souvent traiter des flux continus de données en temps réel. Des systèmes comme Apache Kafka sont utilisés pour la gestion des flux de données en temps réel. | |||

* '''Systèmes de Gestion de Cluster''' : Les gestionnaires de cluster, tels que Apache Hadoop YARN et Kubernetes, sont utilisés pour coordonner et gérer les ressources informatiques sur des clusters de serveurs. | |||

* '''Systèmes de Gestion de Configuration''' : Des outils tels que Apache ZooKeeper sont utilisés pour la gestion de la configuration, la synchronisation et la gestion des services distribués. | |||

* '''Outils d'Analyse et de Visualisation''' : Des outils d'analyse de données tels que Apache Spark MLlib, TensorFlow pour l'apprentissage automatique, et des outils de visualisation tels que Tableau, sont souvent intégrés pour extraire des informations significatives à partir des données. | |||

* '''Sécurité et Gestion d'Accès''' : Les solutions de sécurité, telles que Kerberos, sont essentielles pour protéger les données dans des environnements Big Data. Des mécanismes de gestion des accès et de gouvernance sont également mis en œuvre pour assurer la conformité. | |||

* '''Cloud Computing''' : De nombreuses entreprises optent également pour des solutions de cloud computing, telles qu'Amazon Web Services (AWS), Microsoft Azure, et Google Cloud Platform, pour déployer leurs infrastructures Big Data sans avoir à gérer directement l'infrastructure matérielle. | |||

Ces composants peuvent être utilisés ensemble pour créer des architectures Big Data adaptées aux besoins spécifiques d'une organisation. L'évolution rapide du domaine du Big Data a conduit à l'émergence de nombreuses technologies et solutions, et les organisations peuvent choisir les composants qui correspondent le mieux à leurs besoins particuliers. | |||

=== Data lake === | === Data lake === | ||

https://www.lebigdata.fr/data-lake-definition | https://www.lebigdata.fr/data-lake-definition | ||

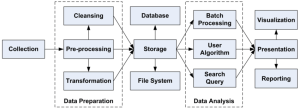

== Processus général == | |||

[[Fichier:The-big-data-process-flow-IV-SYSTEM-ARCHITECTURE-AND-BUILDING-BLOCKS.png|alt=The-big-data-process-flow-IV-SYSTEM-ARCHITECTURE-AND-BUILDING-BLOCKS|vignette|The-big-data-process-flow-IV-SYSTEM-ARCHITECTURE-AND-BUILDING-BLOCKS <ref>Zhang, Xiao & Wu, Panfeng & Tan, Chao. (2017). A big data framework for spacecraft prognostics and health monitoring. 1-7. 10.1109/PHM.2017.8079320. https://www.researchgate.net/publication/320650324_A_big_data_framework_for_spacecraft_prognostics_and_health_monitoring</ref>]] | |||

Une description générale du processus Big Data : | |||

* '''Collecte des données''' : La première étape consiste à rassembler des données provenant de différentes sources. Ces sources peuvent inclure des appareils connectés, des capteurs, des médias sociaux, des transactions en ligne, des bases de données traditionnelles, et bien d'autres. | |||

* '''Stockage des données''' : Une fois les données collectées, elles sont stockées dans des systèmes de stockage de données distribués, tels que des bases de données NoSQL, des data lakes ou des entrepôts de données. Ces systèmes sont conçus pour gérer de grandes quantités de données de manière efficace. | |||

* '''Traitement des données''' : Le traitement des données consiste à nettoyer, transformer et organiser les données de manière à les rendre utilisables. Cela peut impliquer la suppression des données redondantes, la normalisation des formats, et d'autres opérations pour préparer les données à l'analyse. | |||

* '''Analyse des données''' : Une fois que les données sont préparées, elles peuvent être analysées pour extraire des informations significatives. Les outils d'analyse de données, tels que les algorithmes d'apprentissage automatique, les méthodes statistiques et les techniques de fouille de données, sont utilisés pour identifier des tendances, des schémas et des relations dans les données. | |||

* '''Visualisation des données''' : Les résultats de l'analyse peuvent être représentés visuellement à l'aide de graphiques, de tableaux de bord et d'autres outils de visualisation. Cela permet aux utilisateurs de comprendre plus facilement les tendances et les insights issus des données. | |||

* '''Interprétation des résultats''' : Les résultats de l'analyse sont interprétés pour prendre des décisions éclairées. Cela peut inclure des recommandations commerciales, des ajustements de processus ou d'autres actions basées sur les insights tirés des données. | |||

* '''Optimisation et itération''' : Le processus Big Data est souvent itératif. Après avoir mis en œuvre des changements ou des ajustements basés sur les résultats de l'analyse, les organisations peuvent continuer à collecter, stocker, traiter et analyser des données pour améliorer constamment leurs opérations et leurs performances. | |||

Il est important de noter que le processus exact peut varier en fonction des besoins spécifiques d'une organisation et des technologies utilisées. De plus, d'autres aspects tels que la sécurité des données, la gestion des données en streaming, et la gouvernance des données sont également des considérations importantes dans le contexte du Big Data. | |||

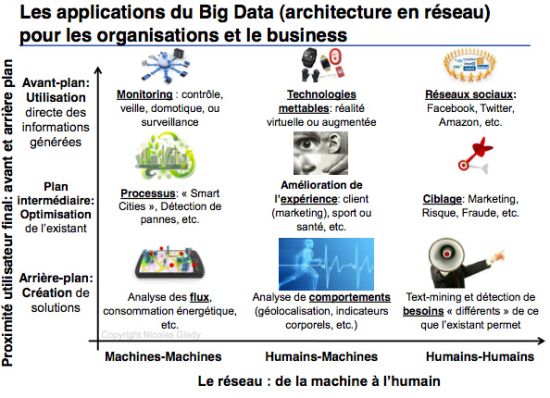

== Applications == | == Applications == | ||

''voir : https://www.lehibou.com/communaute/qui-utilise-big-data'' | |||

[[Fichier:Applications du Big Data.jpg|alt=Applications du Big Data|vignette|550x550px|Applications du Big Data<ref>https://www.hbrfrance.fr/chroniques-experts/2014/05/2273-quelles-applications-concretes-pour-le-big-data/</ref>]]Le Big Data, qui se réfère à l'analyse et à l'utilisation de vastes ensembles de données, a des applications diverses et impacte de nombreux secteurs. Voici quelques exemples d'applications du Big Data dans différents domaines : | |||

* '''Santé''' : | |||

** '''Analyse prédictive''' : Le Big Data est utilisé pour prévoir les épidémies, améliorer la gestion des stocks de médicaments, et optimiser les ressources dans les établissements de santé. | |||

** '''Personnalisation des soins''' : Les données sur la santé des patients peuvent être utilisées pour personnaliser les traitements, identifier les facteurs de risque et améliorer les résultats. | |||

* '''Finance''' : | |||

** '''Gestion des risques''' : Les institutions financières utilisent le Big Data pour évaluer les risques de crédit, détecter la fraude et optimiser les portefeuilles d'investissements. | |||

** '''Analyse de marché''' : Les données volumineuses aident à comprendre les tendances du marché, à prédire les mouvements financiers et à prendre des décisions éclairées. | |||

* '''Commerce électronique :''' | |||

** '''Recommandations personnalisées''' : Les plateformes de commerce électronique utilisent le Big Data pour recommander des produits basés sur les historiques d'achat et les préférences des utilisateurs. | |||

** '''Gestion des stocks''' : L'analyse des données peut optimiser la gestion des stocks en prédisant la demande et en minimisant les surplus ou les ruptures de stock. | |||

* '''Transport''' : | |||

** '''Optimisation des itinéraires''' : Les données de localisation et de trafic sont utilisées pour optimiser les itinéraires de livraison, réduisant ainsi les coûts et améliorant l'efficacité. | |||

** '''Planification des transports en commun''' : Le Big Data aide à planifier les horaires de transport en commun en fonction des habitudes de déplacement des passagers. | |||

* '''Énergie''' : | |||

** '''Gestion de la demande''' : Les entreprises énergétiques utilisent le Big Data pour prévoir la demande d'énergie, améliorant ainsi l'efficacité de la production et de la distribution. | |||

** '''Optimisation des réseaux intelligents''' : Les données sont utilisées pour optimiser les réseaux d'énergie intelligents, améliorant la fiabilité et la durabilité. | |||

* '''Éducation''' : | |||

** '''Personnalisation de l'apprentissage''' : Les systèmes éducatifs utilisent le Big Data pour adapter les programmes d'études en fonction des besoins individuels des étudiants. | |||

** '''Analyse des performances''' : Les données sont analysées pour évaluer l'efficacité des méthodes d'enseignement et identifier les domaines d'amélioration. | |||

* '''Télécommunications''' : | |||

** '''Gestion du réseau''' : Les opérateurs de télécommunications utilisent le Big Data pour surveiller et optimiser les performances du réseau, anticipant ainsi les problèmes potentiels. | |||

** '''Analyse de la clientèle''' : Les données client aident les entreprises de télécommunications à personnaliser les offres et à améliorer l'expérience utilisateur. | |||

Ces exemples illustrent la diversité des applications du Big Data et montrent comment l'analyse des données massives peut apporter des avantages significatifs dans de nombreux secteurs différents. | |||

== Familles de calcul == | == Familles de calcul == | ||

[[Fichier:Tableau des quatre familles de calcul.png|alt=Dominique Cardon, tableau illustrant les quatre familles de calcul différentes (2015) Capture d’écran tirée de la version électronique de l’ouvrage de Dominique Cardon, À quoi rêvent les algorithmes? Nos vies à l’heure des big data, Paris, Seuil, 2015, p. 91 | ''voir : https://fr.slideshare.net/dominiquecardon/les-mtriques-de-visibilit-a-ct-audessus-dedans-endessous-du-web''[[Fichier:Tableau des quatre familles de calcul.png|alt=Dominique Cardon, tableau illustrant les quatre familles de calcul différentes (2015) Capture d’écran tirée de la version électronique de l’ouvrage de Dominique Cardon, À quoi rêvent les algorithmes? Nos vies à l’heure des big data, Paris, Seuil, 2015, p. 91 |vignette|500x500px|Dominique Cardon, tableau illustrant les quatre familles de calcul différentes (2015) <ref name=":0">Dominique Cardon, ''À quoi rêvent les algorithmes? Nos vies à l’heure des big data'', Paris, Seuil, 2015, p. 91 </ref>]]Dominique Cardon, dans son livre "À quoi rêvent les algorithmes : Nos vies à l'heure des big data" (Seuil, 2015)<ref name=":0" />, propose '''une classification des algorithmes en fonction de leur position dans la chaîne informationnelle, qu'il décrit comme "au-dessus", "en-dessous", "à côté" et "dedans". Cela concerne la façon dont les algorithmes influent sur la manière dont l'information est organisée et diffusée dans notre société.''' Voici une explication de chaque catégorie : | ||

* '''Algorithmes "En dessous"''' : Ces algorithmes travaillent au niveau infrastructural. Ils sont souvent invisibles pour les utilisateurs finaux, mais ils façonnent la manière dont les données sont stockées, traitées et acheminées. Ils peuvent inclure des algorithmes de gestion de bases de données, des protocoles de communication, etc. | |||

* '''Algorithmes "Au-dessus"''' : Ces algorithmes opèrent à un niveau plus visible pour les utilisateurs. Il s'agit notamment des algorithmes de recommandation, de personnalisation ou de classement qui influent sur ce que les utilisateurs voient en ligne, comme sur les réseaux sociaux ou les plateformes de commerce électronique. | |||

* '''Algorithmes "À côté"''' : Ces algorithmes fonctionnent de manière collaborative avec les utilisateurs. Ils peuvent être des algorithmes de filtrage collaboratif, où les utilisateurs contribuent à la recommandation en fonction de leurs propres actions et préférences. | |||

* '''Algorithmes "Dedans"''' : Il s'agit des algorithmes intégrés dans des objets ou des systèmes. Par exemple, les algorithmes présents dans les objets connectés, les applications mobiles, ou d'autres technologies que nous utilisons au quotidien. | |||

'''Cette classification met en lumière la diversité des rôles que jouent les algorithmes dans notre vie quotidienne, depuis leur impact infrastructurel jusqu'à leur influence sur ce que nous voyons et expérimentons en tant qu'utilisateurs finaux. Elle souligne également comment les algorithmes peuvent être intégrés dans différentes couches de nos interactions avec les technologies numériques.''' | |||

== Références == | == Références == | ||

Version actuelle datée du 15 novembre 2023 à 21:36

| ←Modéliser | ⌂ retour | Accès à l'information → |

Définition

"On parle depuis quelques années du phénomène de big data , que l’on traduit souvent par « données massives ». Avec le développement des nouvelles technologies, d’internet et des réseaux sociaux ces vingt dernières années, la production de données numériques a été de plus en plus nombreuse : textes, photos, vidéos, etc. Le gigantesque volume de données numériques produites combiné aux capacités sans cesse accrues de stockage et à des outils d’analyse en temps réel de plus en plus sophistiqués offre aujourd’hui des possibilités inégalées d’exploitation des informations. Les ensembles de données traités correspondant à la définition du big data répondent à trois caractéristiques principales : volume, vélocité et variété."[1]

Les V

Le terme "Big Data" fait référence à des ensembles de données extrêmement volumineux, complexes et variables qui dépassent souvent la capacité des systèmes informatiques traditionnels à les gérer et à les analyser efficacement. Le Big Data est caractérisé par les "trois V" suivants :

- Volume : Le Big Data implique des quantités massives de données. Ces données peuvent provenir de diverses sources telles que les transactions commerciales, les réseaux sociaux, les capteurs, les dispositifs IoT (Internet des objets), les données générées par les utilisateurs, etc. La taille des ensembles de données est souvent mesurée en téraoctets, pétaoctets, voire exaoctets.

- Variété : Le Big Data peut prendre différentes formes, notamment des données structurées, semi-structurées et non structurées. Les données structurées sont organisées de manière tabulaire (par exemple, bases de données relationnelles), les données semi-structurées ont une certaine structure mais ne rentrent pas parfaitement dans des tables (par exemple, JSON, XML), tandis que les données non structurées, comme les vidéos, les images, les textes libres, ne suivent généralement aucune structure prédéfinie.

- Vélocité : Le Big Data est généré à des vitesses élevées. Les données peuvent être créées en temps réel ou à un rythme très rapide, comme dans le cas des flux de données en continu. La capacité à traiter et à analyser ces données en temps réel est souvent cruciale dans un environnement Big Data.

Au fil du temps, d'autres caractéristiques ont été ajoutées pour décrire le Big Data, telles que la variabilité (la capacité à gérer des données dont les caractéristiques changent avec le temps) et la véracité (la qualité des données et la confiance dans leur précision).

Pour traiter et tirer des informations significatives de ces ensembles de données massifs, de nouvelles technologies et méthodologies ont émergé, notamment le traitement parallèle, le stockage distribué, les bases de données NoSQL, les technologies de traitement en temps réel, l'apprentissage automatique, etc. Le Big Data est utilisé dans une variété de secteurs, y compris le commerce, la santé, la finance, les sciences, la recherche, et bien d'autres, pour prendre des décisions éclairées, découvrir des tendances et optimiser les opérations.

https://infonet.fr/lexique/definitions/big-data/

- la vélocité : la grande rapidité à laquelle les données sont créées, stockées et analysées

- le volume : il n’y a pas de fin, le nombre de données ne cesse de croître

- la variété : elles peuvent provenir de différentes sources et se présenter sous différentes formes

Infrastructure

Les infrastructures Big Data sont constituées de technologies matérielles, logicielles et réseau conçues pour gérer, stocker, traiter et analyser des ensembles de données massives et complexes. Ces infrastructures sont essentielles pour tirer parti des avantages du Big Data en fournissant la puissance de calcul et les ressources nécessaires pour manipuler d'énormes volumes de données. Voici quelques composants clés des infrastructures Big Data :

- Stockage Distribué : Les systèmes de stockage distribué sont utilisés pour stocker des volumes massifs de données sur plusieurs nœuds ou serveurs. Hadoop Distributed File System (HDFS) est un exemple courant de système de stockage distribué dans l'écosystème Hadoop.

- Traitement Distribué : Les frameworks de traitement distribué permettent de traiter des données à grande échelle en parallèle sur un cluster de serveurs. Apache Hadoop MapReduce est un exemple classique de framework de traitement distribué, mais d'autres, comme Apache Spark, sont également largement utilisés.

- Systèmes de Gestion de Base de Données NoSQL : Les bases de données NoSQL, telles que MongoDB, Cassandra, et Couchbase, sont utilisées pour gérer des données non structurées ou semi-structurées, offrant une flexibilité supérieure à celle des bases de données relationnelles traditionnelles.

- Systèmes de Gestion de Flux de Données : Les infrastructures Big Data doivent souvent traiter des flux continus de données en temps réel. Des systèmes comme Apache Kafka sont utilisés pour la gestion des flux de données en temps réel.

- Systèmes de Gestion de Cluster : Les gestionnaires de cluster, tels que Apache Hadoop YARN et Kubernetes, sont utilisés pour coordonner et gérer les ressources informatiques sur des clusters de serveurs.

- Systèmes de Gestion de Configuration : Des outils tels que Apache ZooKeeper sont utilisés pour la gestion de la configuration, la synchronisation et la gestion des services distribués.

- Outils d'Analyse et de Visualisation : Des outils d'analyse de données tels que Apache Spark MLlib, TensorFlow pour l'apprentissage automatique, et des outils de visualisation tels que Tableau, sont souvent intégrés pour extraire des informations significatives à partir des données.

- Sécurité et Gestion d'Accès : Les solutions de sécurité, telles que Kerberos, sont essentielles pour protéger les données dans des environnements Big Data. Des mécanismes de gestion des accès et de gouvernance sont également mis en œuvre pour assurer la conformité.

- Cloud Computing : De nombreuses entreprises optent également pour des solutions de cloud computing, telles qu'Amazon Web Services (AWS), Microsoft Azure, et Google Cloud Platform, pour déployer leurs infrastructures Big Data sans avoir à gérer directement l'infrastructure matérielle.

Ces composants peuvent être utilisés ensemble pour créer des architectures Big Data adaptées aux besoins spécifiques d'une organisation. L'évolution rapide du domaine du Big Data a conduit à l'émergence de nombreuses technologies et solutions, et les organisations peuvent choisir les composants qui correspondent le mieux à leurs besoins particuliers.

Data lake

https://www.lebigdata.fr/data-lake-definition

Processus général

Une description générale du processus Big Data :

- Collecte des données : La première étape consiste à rassembler des données provenant de différentes sources. Ces sources peuvent inclure des appareils connectés, des capteurs, des médias sociaux, des transactions en ligne, des bases de données traditionnelles, et bien d'autres.

- Stockage des données : Une fois les données collectées, elles sont stockées dans des systèmes de stockage de données distribués, tels que des bases de données NoSQL, des data lakes ou des entrepôts de données. Ces systèmes sont conçus pour gérer de grandes quantités de données de manière efficace.

- Traitement des données : Le traitement des données consiste à nettoyer, transformer et organiser les données de manière à les rendre utilisables. Cela peut impliquer la suppression des données redondantes, la normalisation des formats, et d'autres opérations pour préparer les données à l'analyse.

- Analyse des données : Une fois que les données sont préparées, elles peuvent être analysées pour extraire des informations significatives. Les outils d'analyse de données, tels que les algorithmes d'apprentissage automatique, les méthodes statistiques et les techniques de fouille de données, sont utilisés pour identifier des tendances, des schémas et des relations dans les données.

- Visualisation des données : Les résultats de l'analyse peuvent être représentés visuellement à l'aide de graphiques, de tableaux de bord et d'autres outils de visualisation. Cela permet aux utilisateurs de comprendre plus facilement les tendances et les insights issus des données.

- Interprétation des résultats : Les résultats de l'analyse sont interprétés pour prendre des décisions éclairées. Cela peut inclure des recommandations commerciales, des ajustements de processus ou d'autres actions basées sur les insights tirés des données.

- Optimisation et itération : Le processus Big Data est souvent itératif. Après avoir mis en œuvre des changements ou des ajustements basés sur les résultats de l'analyse, les organisations peuvent continuer à collecter, stocker, traiter et analyser des données pour améliorer constamment leurs opérations et leurs performances.

Il est important de noter que le processus exact peut varier en fonction des besoins spécifiques d'une organisation et des technologies utilisées. De plus, d'autres aspects tels que la sécurité des données, la gestion des données en streaming, et la gouvernance des données sont également des considérations importantes dans le contexte du Big Data.

Applications

voir : https://www.lehibou.com/communaute/qui-utilise-big-data

Le Big Data, qui se réfère à l'analyse et à l'utilisation de vastes ensembles de données, a des applications diverses et impacte de nombreux secteurs. Voici quelques exemples d'applications du Big Data dans différents domaines :

- Santé :

- Analyse prédictive : Le Big Data est utilisé pour prévoir les épidémies, améliorer la gestion des stocks de médicaments, et optimiser les ressources dans les établissements de santé.

- Personnalisation des soins : Les données sur la santé des patients peuvent être utilisées pour personnaliser les traitements, identifier les facteurs de risque et améliorer les résultats.

- Finance :

- Gestion des risques : Les institutions financières utilisent le Big Data pour évaluer les risques de crédit, détecter la fraude et optimiser les portefeuilles d'investissements.

- Analyse de marché : Les données volumineuses aident à comprendre les tendances du marché, à prédire les mouvements financiers et à prendre des décisions éclairées.

- Commerce électronique :

- Recommandations personnalisées : Les plateformes de commerce électronique utilisent le Big Data pour recommander des produits basés sur les historiques d'achat et les préférences des utilisateurs.

- Gestion des stocks : L'analyse des données peut optimiser la gestion des stocks en prédisant la demande et en minimisant les surplus ou les ruptures de stock.

- Transport :

- Optimisation des itinéraires : Les données de localisation et de trafic sont utilisées pour optimiser les itinéraires de livraison, réduisant ainsi les coûts et améliorant l'efficacité.

- Planification des transports en commun : Le Big Data aide à planifier les horaires de transport en commun en fonction des habitudes de déplacement des passagers.

- Énergie :

- Gestion de la demande : Les entreprises énergétiques utilisent le Big Data pour prévoir la demande d'énergie, améliorant ainsi l'efficacité de la production et de la distribution.

- Optimisation des réseaux intelligents : Les données sont utilisées pour optimiser les réseaux d'énergie intelligents, améliorant la fiabilité et la durabilité.

- Éducation :

- Personnalisation de l'apprentissage : Les systèmes éducatifs utilisent le Big Data pour adapter les programmes d'études en fonction des besoins individuels des étudiants.

- Analyse des performances : Les données sont analysées pour évaluer l'efficacité des méthodes d'enseignement et identifier les domaines d'amélioration.

- Télécommunications :

- Gestion du réseau : Les opérateurs de télécommunications utilisent le Big Data pour surveiller et optimiser les performances du réseau, anticipant ainsi les problèmes potentiels.

- Analyse de la clientèle : Les données client aident les entreprises de télécommunications à personnaliser les offres et à améliorer l'expérience utilisateur.

Ces exemples illustrent la diversité des applications du Big Data et montrent comment l'analyse des données massives peut apporter des avantages significatifs dans de nombreux secteurs différents.

Familles de calcul

Dominique Cardon, dans son livre "À quoi rêvent les algorithmes : Nos vies à l'heure des big data" (Seuil, 2015)[6], propose une classification des algorithmes en fonction de leur position dans la chaîne informationnelle, qu'il décrit comme "au-dessus", "en-dessous", "à côté" et "dedans". Cela concerne la façon dont les algorithmes influent sur la manière dont l'information est organisée et diffusée dans notre société. Voici une explication de chaque catégorie :

- Algorithmes "En dessous" : Ces algorithmes travaillent au niveau infrastructural. Ils sont souvent invisibles pour les utilisateurs finaux, mais ils façonnent la manière dont les données sont stockées, traitées et acheminées. Ils peuvent inclure des algorithmes de gestion de bases de données, des protocoles de communication, etc.

- Algorithmes "Au-dessus" : Ces algorithmes opèrent à un niveau plus visible pour les utilisateurs. Il s'agit notamment des algorithmes de recommandation, de personnalisation ou de classement qui influent sur ce que les utilisateurs voient en ligne, comme sur les réseaux sociaux ou les plateformes de commerce électronique.

- Algorithmes "À côté" : Ces algorithmes fonctionnent de manière collaborative avec les utilisateurs. Ils peuvent être des algorithmes de filtrage collaboratif, où les utilisateurs contribuent à la recommandation en fonction de leurs propres actions et préférences.

- Algorithmes "Dedans" : Il s'agit des algorithmes intégrés dans des objets ou des systèmes. Par exemple, les algorithmes présents dans les objets connectés, les applications mobiles, ou d'autres technologies que nous utilisons au quotidien.

Cette classification met en lumière la diversité des rôles que jouent les algorithmes dans notre vie quotidienne, depuis leur impact infrastructurel jusqu'à leur influence sur ce que nous voyons et expérimentons en tant qu'utilisateurs finaux. Elle souligne également comment les algorithmes peuvent être intégrés dans différentes couches de nos interactions avec les technologies numériques.

Références

- ↑ https://www.cnil.fr/fr/definition/big-data

- ↑ https://visionarymarketing.com/fr/2013/10/big-data-exemples/

- ↑ Hilbert, M., & López, P. (2011). The world’s technological capacity to store, communicate, and compute information. science, 332(6025), 60-65.

- ↑ Zhang, Xiao & Wu, Panfeng & Tan, Chao. (2017). A big data framework for spacecraft prognostics and health monitoring. 1-7. 10.1109/PHM.2017.8079320. https://www.researchgate.net/publication/320650324_A_big_data_framework_for_spacecraft_prognostics_and_health_monitoring

- ↑ https://www.hbrfrance.fr/chroniques-experts/2014/05/2273-quelles-applications-concretes-pour-le-big-data/

- ↑ 6,0 et 6,1 Dominique Cardon, À quoi rêvent les algorithmes? Nos vies à l’heure des big data, Paris, Seuil, 2015, p. 91