Ingénierie des Interfaces Homme Machine

Interaction Homme Machine

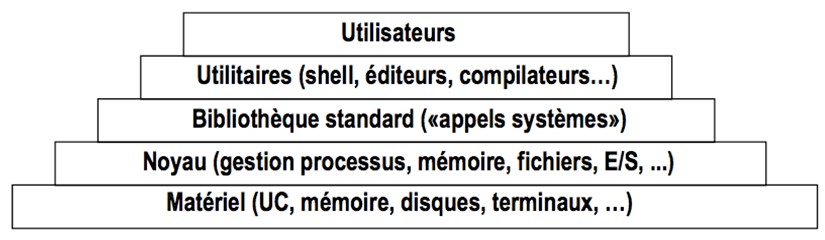

L’interaction homme machine est indissociable de la notion d’interface. L’interface dans une acception informatique peut être définie comme une « jonction entre deux matériels ou logiciels leur permettant d'échanger des informations par l'adoption de règles communes physiques ou logiques » [1]. Elle peut également être définie comme « logique intermédiaire entre deux traitements distincts, ou entre un traitement et un fichier »[1]. La première définition fait apparaître le fait que l’interface et un point d’ancrage entre des entités pouvant être physiques et logicielles. Ce point d’ancrage est défini pour permettre l’échange en s’appuyant sur des règles qui sont qualifiées de physiques ou logiques. L’interface peut en effet correspondre à la spécification d’éléments d’interconnexion, comme des prises dans une dimension physique, ou à la définition d’une logique implantée ou programmée, pouvant prendre la forme d’un protocole de communication réseau. Dans la dimension logique, on se rapproche du logiciel et de la manipulation et la communication de données abstraites stockées en mémoire. La seconde définition se concentre plus sur cette dimension logicielle et conceptuelle évoquant les notions de traitement et de fichier, qui correspondent en fait à la manipulation de données. A ce niveau, l’interface est implantée pour mettre en œuvre le concept d’abstraction inhérent à l’informatique. L’accès aux fonctionnalités de bas niveau de la machine se fait en traversant un empilement de couches d’abstractions accessibles chacune via des interfaces.

Au plus haut de cet empilement se trouve l’utilisateur humain. On aborde alors la problématique de l’interaction homme machine. Dans ce champ disciplinaire l’interface peut être définie comme « le moyen de communication entre l’homme et le système »[2]. La notion de système est introduite ici . Elle représente une notion plus générale qui diminue la connotation matérielle et technologique de l’expression « Interface Homme Machine » pour élargir aux problématiques d’accès au données contenues dans la machine. L’interface est ici vue comme un langage, les mécanismes interactifs disponibles n’étant alors que des moyens de ce langage pour accéder, commander, communiquer.

Le domaine de l’interaction homme machine est un champ disciplinaire très vaste que l’on peut toutefois dissocier selon qu’il se focalise sur les dimensions matérielle ou logicielle évoquées précédemment. Dans sa dimension matérielle, l’interaction homme machine s’intéresse à l’étude et au développement de périphériques permettant de communiquer avec tout type de machine. Il s’agit par exemple des périphériques de pointage ou de saisie, l’exemple caractéristique étant la souris présentée en 1963 et inventée par Doug Engalbert. Dans cet axe de recherche, c’est notamment l’efficacité des dispositifs produits au regard de la tâche à instrumenter qui guide les développements, l’orientation étant d’améliorer la performance de l’humain dans la réalisation de cette tâche.

L’interaction homme machine peut également être abordée selon une dimension plus logicielle et conceptuelle. En s’appuyant sur les couches d’abstractions existantes et déjà implantées, on s’écarte sensiblement de la dimension matérielle pour se rapprocher de la logique programmée. L’orientation est alors de se recentrer sur l’interaction homme machine, comme un langage, et de se concentrer sur la manière de communiquer les données abstraites contenues en mémoire à un utilisateur. Pour aborder ce champ d’étude, à l’expression interaction homme machine nous préfèrerons interaction homme information.

En introduisant, l’interaction homme information, nous souhaitons aborder l’interaction au regard d’une vue linguistique plutôt que de se concentrer en premier lieu sur la tâche à réaliser. En effet, les concepteurs d’interface « se sont surtout intéressés jusqu'à récemment, à augmenter leurs fonctionnalités et leurs performances » [3]. De plus, la conception d’interface se focalise souvent sur l’activité de l’utilisateur appréhendée comme « l’ensemble des moyens mis en oeuvre par l'utilisateur pour atteindre ses objectifs » [3]. Les interfaces produites constituent alors des environnements très cadrés, voire même contraignants, qui sont conçus et développés par rapport à des structures de données implantées sans prendre assez en compte la dimension utilisateur et sociale dans lesquelles les interfaces s’insèrent. Ce type d’approche fait partie des facteurs introduisant des difficultés de compréhension et d’appropriation du message que véhiculent les interfaces ou encore les fonctionnalités proposées.

En effet, dans une vue alternative, l’interface peut être abordée comme « la partie manipulable par l'usager qui complète un ensemble d'outils pour lui conférer le statut d'application » [4]. C’est le point de vue de l’ergonomie qui apparaît ici. L’outil doit être considéré au sens de « tout programme d’intérêt très général applicable à la résolution de problèmes divers » [5]en concordance avec la notion d’outil introduite par Rabardel [6], c’est à dire un artefact conçu pour assister une tâche. Vient ensuite la notion d’application définit comme « tout programme spécialisé dans le traitement d'un type de problème concret donné, l'homme intervenant explicitement dans ce traitement » [5]. Cette notion d’application prend en considération l’intervention humaine dans l’utilisation et la valorisation de l’outil proposé. En extension, cette notion d’application peut être rapprochée de la notion d’instrument, proposée par Rabardel qui doit être prise en compte dans le développement d’un interface. En effet, Rabardel introduit ce passage de l’outil à l’instrument lorsque l’outil intègre une activité métier. L’utilisateur va se l’approprier et surtout construire des shèmes d’utilisation de l’outil qui lui sont propres. Les schèmes d’utilisation correspondent à des modes d’utilisation de l’outil propres à chaque utilisateur, développés dans le contexte de l’activité. Ainsi, « l'activité effective de l'outil est le plus souvent irréductiblement différente de la tâche initialement prévue. L'agent redéfinit la tâche et l'exécute d'une façon particulière [3].

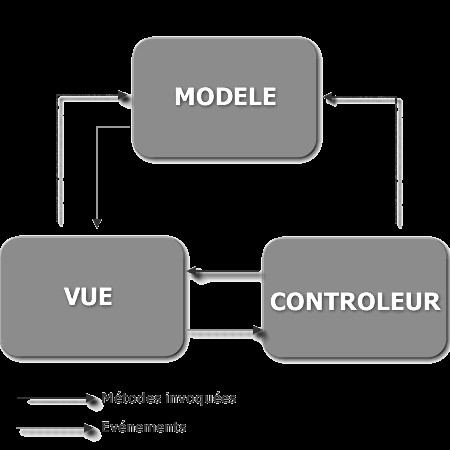

La problématique de l’interface ne se cantonne alors plus au développement d’une représentation graphique pour faire transiter des informations ainsi que les mécanismes permettant de les manipuler [7]. L’interface s’insère dans une logique de système pas uniquement limitée au système informatique. La notion de système s’étend à l’activité métier et donc à la prise en compte d’une dimension humaine introduisant une variabilité inter individuelle [3] et une dimension sociale et culturelle. Ces facteurs rendent le problème moins établi du fait que l’interface doit être capable de supporter le changement. Dans ce contexte, « les méthodes classiques de conception pour l’utilisabilité fondée sur l’analyse et la modélisation des tâches n’accordent que peu de place à la gestion du changement et de son rôle dans l’organisation. » [8]. Cette gestion du changement met en avant l’importance de la flexibilité et de la malléabilité [8] des interfaces développées. Dans cette direction, la conception d’interface selon l’approche modèle vue contrôleur (MVC : model view controler (Krasmer et Pope 1988)) constitue une avancée introduisant une indépendance entre les données, leur traitement et leur visualisation :

- Le modèle traduit la couche applicative en se focalisant sur les données et leur bonne structuration. Il inclut également un ensemble de services, permettant de s’interconnecter avec d’autres systèmes par exemple.

- La vue a la possibilité de communiquer avec le modèle pour accéder aux données. Elle est en charge de calculer une présentation des données, c’est à dire produire une visualisation de données à l’intention des utilisateurs. Il s’agit de la couche interface utilisateur. À proprement parler, il s’agit de parler de « vues » au pluriel car l’indépendance de cette architecture offre une flexibilité, une malléabilité, permettant d’offrir un éventail de visualisations appropriées à chaque situation.

- Le contrôleur est en relation avec la vue et le modèle : il permet de répercuter sur le modèle les actions réalisées par l’utilisateur sur la vue. Il gère également au gré de l’interaction la succession des vues à présenter. Il intègre ainsi la dimension logique de présentation.

Malgré l’apparente flexibilité de ce type d’architecture, une limite reste toujours que l’adaptation d’une interface n’est accessible et reste réservées aux concepteurs [8]. De plus, l’approche MVC est majoritairement mise en œuvre pour adapter la visualisation des données à leur manipulation et leur lecture, notamment dans des domaines où la tâche est bien balisée. Le fait que la tâche soit bien balisée permet de recenser avec précision les données ainsi que les opérations qui devront être disponibles. L’interface qui est alors construite et proposée découle, souvent des structures brutes de données mises en jeu ou d’une saisie procédurale : l’exemple caractéristique est le formulaire.

Ce type d’approche dans un contexte bien balisé appréhende toutefois l’interaction comme très codifiée. On considère alors trop souvent ces interfaces comme intuitives, faisant totalement transparaître les structures de données mises en jeu. On observe pourtant qu’un utilisateur non informaticien peut avoir d’importantes difficultés à comprendre le découpage inhérent aux contraintes de l’informaticien. On est alors confronté aux « limites des approches classiques des IHM basées sur une psychologie de l’humain en tant que processeur d’information » [8]. Par exemple, lors du passage d’une commande via internet, on sera classiquement confronté à une succession de formulaires simples, chacun précisant les informations à fournir. Ceci constitue un domaine bien balisé et l’interface paraît acceptable du fait que le processus est commun et connu des utilisateurs. On s’attend en effet, après avoir valider son panier d’achat, à saisir les informations de livraison et de facturation, puis les informations de paiement. Dans un contexte beaucoup moins défini ou plus complexe, tel qu’un système mettant en jeu une modélisation complexe, la situation sera différente. Il s’agira de réussir à appréhender, par exemple, via une succession de formulaires, le processus et la sémantique. On identifie ici tout l’enjeu de faire appréhender à l’utilisateur non pas uniquement les structures de données mises en jeu mais bien la modélisation et le sens qui y est associé. En ce sens, plutôt que de se focaliser sur l’analyse de l’activité très liée à la manipulation des données, nous préférons nous intéresser à une vue plus linguistique de l’interface. Nous proposons donc dans la section suivante une étude de cette approche linguistique de l’interface qui va nous amener à considérer l’interaction homme machine comme une métacommunication.

De l’interaction homme machine à la métacommunication

La vue linguistique de l’interaction homme information introduit une analogie entre interaction et dialogue entre individus. Cette analogie centre la problématique du développement des interfaces sur la définition de langages. Les mécanismes interactifs proposés, ainsi que les modalités de visualisation de l’information mises en œuvre, ne constitueront que des éléments de ce langage permettant d’initier un dialogue entre l’homme et la machine

Dialogue homme machine

L’étude du dialogue homme machine renvoie aux recherches en intelligence artificielle et à l’apparition des premiers programmes interactifs. Les programmes interactifs se caractérisent par la possibilité d’interagir avec le programme durant son exécution se démarquant d’une conception « donnée – programme - résultat ». Un des premiers systèmes de dialogue est le système ELIZA qui représente un des systèmes de conversation les plus célèbres. Par la suite, des interfaces en langage naturel ont été développés pour accéder aux systèmes experts. Ils étaient basés sur l’utilisation d’ATN (Augmented Transision Network) Sémantique, la génération des phrases étant produite via des patrons de phrases. Un exemple de système extrêmement abouti à ce jour est le système Marlowe, qui correspond à un assistant virtuel d’analyse de discussions argumentées [10], exploité dans le domaine de la sociologie.

Le dialogue homme machine peut être abordé selon plusieurs orientations[11] [12] qui sont :

- Le dialogue entre humains et agents logiciels

- Le dialogue entre humains à travers les machines

- Le dialogue entre agents logiciels.

Nous ne présenterons pas une description exhaustive des recherches dans le domaine du dialogue homme machine. Il s’agit d’un domaine vaste, initié en intelligence artificielle et en linguistique, qui a été largement approfondi dans le cadre du développement de systèmes multi-agents par exemple. Notre positionnement sur l’interaction homme information nous conduit à nous intéresser au dialogue entre humains et agent logiciel même si nous verrons que nous aborderons la problématique du dialogue entre humains au travers des machines.

Initialement, l’étude du dialogue traitait essentiellement du langage oral, le langage écrit n’étant pas considéré comme du dialogue écrit en particulier par la psychologie. La tendance s’est inversée avec l’apparition d’outils de communication tel que le courriel ou la messagerie instantanée (Chat), donnant lieu à de nombreux travaux en communication médiatisée par ordinateur (CMO) [13]. La communication écrite peut donc désormais être appréhendée comme un dialogue.

Un dialogue est constitué d’un échange alterné entre au moins deux sujets [12] : le locuteur (celui qui diffuse) et l’allocutaire (celui qui interprète). Le sens construit dans le dialogue dépend alors d’une co-construction entre les participants (Trognon et Brassac. 1992). L’étude du dialogue homme machine doit donc considérer les énoncés écrits de manière isolée, car ils constituent les éléments d’interaction pouvant être appréhendés comme des actes de langage [14][15]. Il s’agit également de prendre en considération la structure globale du dialogue qui introduit différentes phases, comme la reconnaissance mutuelle, la proposition de sujet, l’acception du sujet ou encore la clôture du dialogue. Enfin, il est essentiel de considérer l’enchaînement conversationnelle. Cet enchaînement entre deux énoncés est, en effet, le facteur qui permet d’assurer une compréhension mutuelle entre les participants au dialogue.

La compréhension mutuelle est en relation avec les informations véhiculées entre les participants. Celle-ci dépend des théories du transfert « qui traitent de la manière dont l’information est véhiculée entre les participants » [11]. Il est ainsi possible d’appréhender le transfert d’information selon 3 aspects :

- physique,

- logique ou social,

- sémiotique.

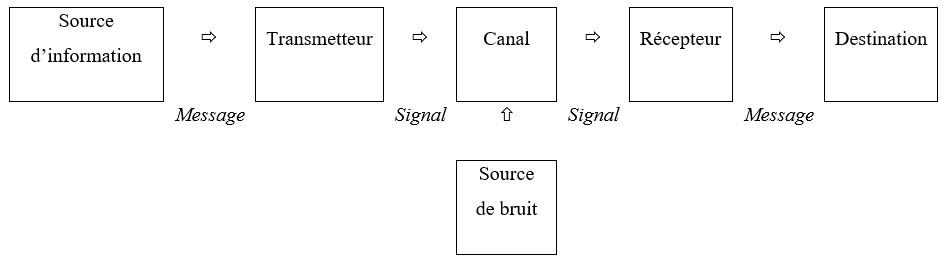

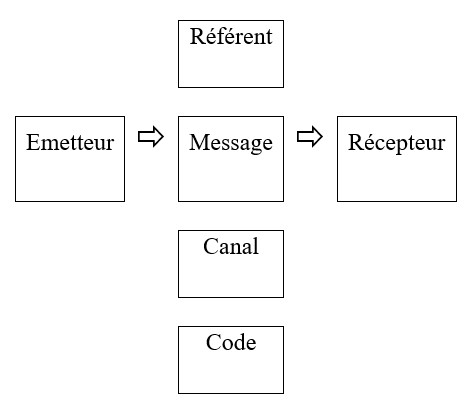

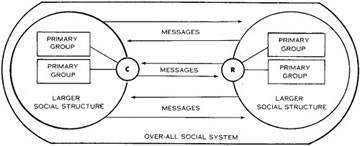

La physique de transfert correspond à la problématique de transmission d’information qui peut être considérée uniquement au niveau signal. Le cadre d’analyse est celui de la théorie de l’information basée sur le modèle de communication de Shannon et Weaver. Le modèle est constitué d’un émetteur et d’un récepteur qui communiquent au travers d’opérations de codage et décodage. L’orientation est ici de transmettre dans des conditions optimales un message à travers un moyen de communication donné. Le code est entièrement défini et doit être connu des participants au dialogue. Jakobson (1961) fait évoluer ce modèle de communication en introduisant la notion de référent. Le code n’est alors plus seulement appréhendé au niveau du signal, mais doit prendre en compte la dimension sociale et sémiotique. En effet, un élément du code, un symbole, a une signification dans un contexte, un référentiel particulier, lié aux acteurs mis en jeu, ainsi que le contexte social dans lequel ils baignent.

Le niveau physique du transfert permet ainsi d’identifier à la fois les propriétés du medium utilisé, ainsi que les propriétés du signal qui peut y être transmis. Ce signal qu’il soit auditif ou écrit constituera la représentation des informations à transmettre. Son interprétation nécessite la connaissance d’un code, qui constitue un métalangage définissant les règles d’organisation des symboles pour produire un énoncé signifiant.

La physique du transfert reste toutefois à un niveau bas d’analyse et appréhende la communication selon un schéma peu en accord avec la réalité. Boullier dans le domaine de l’ingénierie pédagogique évoque ainsi que « certains schémas anciens ont la vie dure pour décrire la communication et celui de Shannon et Weaver où l’étudiant est alors traité comme un récipient qui se remplit, sans autre travail, des contenus qui lui sont déversés. Ce schéma de la communication technique continue de faire des ravages dans les représentations des processus éducatifs : les révisions systémiques (il y a du feed-back) ou à la mode de Jakobson (il y a codage et décodage) ne cherchent pas à remettre en cause les évidences selon lesquelles il serait possible d’identifier un émetteur et un récepteur, » [16]. En effet, la communication ne peut être appréhendée comme unilatérale puisque communiquer c’est avant tout « agir sur l’autre » [17]. L’introduction de la notion de référent est toutefois intéressante dans le modèle de Jackobson puisqu’elle introduit déjà, pour partie, la dimension sémiotique que nous aborderons par la suite.

La logique de transfert renvoie à la dimension sociale du dialogue. Il s’agit de caractériser dans l’enchaînement conversationnel l’inversion des rôles de locuteur et d’alocutaire des participants. Le locuteur est en position de diffusion de l’information. Il produit des signaux avec un code qu’il a choisi ou sur lequel il s’est formé un consensus par exemple dans la phase initiale du dialogue. L’alocutaire se place en position d’interprétant. Il s’agit pour lui d’associer un sens aux signaux qu’il perçoit. L’alocutaire aura alors tendance à interpréter les signaux perçus selon ses spécificités. C’est à ce stade que nous pouvons introduire l’aspect sémiotique du transfert.

La Sémiotique du transfert est au cœur du processus de construction du sens entre les participants au dialogue. Elle renvoie aux problématiques de représentation, représentation du monde et à la construction de terrain commun. Lorsque deux individus dialoguent, chacun se construit une représentation de l’autre et de l’environnement dans lequel le dialogue a lieu : c’est ce que nous nommerons une représentation du monde. Elle est propre à chacun. Elle est influencée par l’origine et l’histoire de chaque individu. C’est à partir de là que se construisent les systèmes de référence sur lesquels se basent l’interprétation. L’ambiguïté du langage naturel, qui est polysémique, peut poser des difficultés dans la construction de ce terrain commun. Chaque acteur interprétera les énoncés selon son propre système de référence. Ceci explique les situations d’incompréhension, par exemple, entre les participants au dialogue qui vont permettre de faire évoluer les systèmes de référence de chacun pour développer un terrain commun entre les acteurs. C’est au sein de ce terrain commun que doit se placer la définition du code inhérent à la physique du transfert, ainsi que la définition et l’alternance des rôles de la logique du transfert. Le terrain est donc en évolution constante venant faire évoluer la limite d’un modèle de transmission basé sur un code déterministe, puisque celui-ci va se construire dynamiquement : cette vue de la communication peut être rapprochée du modèle de Riley (1959).

Dans le développement d’un dialogue homme machine, il s’agit d’attacher un soin particulier à la sémiotique du transfert même si le mode d’interaction au travers de l’écran, du clavier et de la souris ne permette pas une construction du terrain commun aussi aisée qu’entre deux individus. Cependant, homme et ordinateur possèdent leur propre représentation du monde, celle de la machine étant beaucoup plus figée, même si elle peut évoluer, mais au prix de mécanismes complexes, comme des systèmes d’apprentissage. Dans bien des cas, la représentation du monde de la machine ne peut évoluer que modestement, rendant difficile une réelle construction, par les deux parties en présence, d’un terrain commun. Il s’agit alors, d’une certaine manière, d’anticiper la construction de ce terrain commun.

Si bien évidemment l’ordinateur ne peut faire évoluer sa représentation du monde dans une large mesure, il sera par contre capable de fournir des informations qui précisent la signification des signaux qu’il transmet. Il s’agit, dans un premier temps, de rendre explicite au niveau de l’interface le système sémiotique inhérent à la visualisation proposée ainsi que les mécanismes interactifs disponibles. Il est également nécessaire de s’appuyer sur les codes culturels et de domaine des futurs utilisateurs. L’interface doit alors se baser sur leurs systèmes de référence dans l’idée de faciliter leur compréhension et leur utilisation. Dans la section suivante, nous traitons plus précisément le lien entre sémiotique et interface.

Sémiotique et IHM

« the system’s interface can be perceived as a communication generation artifact » [19]

L’interface est ici évoquée comme pouvant être perçues à l’image d’un artefact générateur de communication. Dans cette perspective, la dimension sémiotique de l’interface est un fondement du message qui sera véhiculé. De la bonne compréhension de ce message dépend l’appropriation de l’interface ainsi que son utilisabilité[1] (Mallein et Tarozzi 2002).

L’interface constitue, en effet, un ensemble signes qui va mettre chaque utilisateur face à une situation sémiotique [20], une situation d’interprétation de ce qui lui est proposé. Ce type de situation sémiotique au regard de l’interface est évoqué par de [21] comme : « From the signs exchanged through Input/Output screens, users build a cascade of interpretants [Peirce'31] that eventually crystallize into the user's assigned meaning for the interface message --- the Application's Usability Model » . Ainsi, l’ensemble des signaux véhiculés par l’interface, en entrée et en sortie, au travers de l’écran, peuvent être appréhendés comme des signes. Ces signaux tiennent tout aussi bien aux éléments qui constituent la forme de visualisation proposée qu’aux mécanismes interactifs implantés et disponibles.

Il est alors crucial que l’utilisateur interprète ces différents signes de la manière dont les concepteurs de l’interface les ont imaginés : ceci renvoie à la problématique de compréhension entre deux énoncés évoqués précédemment en dialogue. De plus, il est nécessaire que ce travail interprétatif ne soit pas trop lourd et complexe, au risque d’induire des charges cognitives importantes chez l’utilisateur [21]. Tout ceci souligne l’importance de ne pas concevoir et développer l’interface uniquement au regard de la tâche et de la manipulation des données mais également de véhiculer au travers de son utilisation le niveau métalinguistique qui caractérise la sémantique des signes dont elle est constituée [21].

Ainsi, « il est de la responsabilité de chaque concepteur d'application de se soucier de l'homogénéité du système sémiotique qu'il utilise » [7]. Cette homogénéité est largement pratiquée (cf. Figure 25) dans le développement des interfaces WIMP (« Windows, Icons, Menus and Pointing device ») qui introduisent par exemple une standardisation des icône facilitant leur compréhension : les icône répondent alors à un « code sémiotique standardisé » [7] . Cette notion est également pratiquée au niveau des mécanismes interactifs, tel que raccourcis clavier répondant aux mêmes combinaisons de touches d’une application à une autre, d’un système d’exploitation à un autre.

Si cette standardisation est pratiquée dans de nombreuses applications largement déployées, dans le cadre de visualisation d’information et des mécanismes interactifs communs et bien balisés (copier = ctrl + c, coller = ctrl + v), elle peut être plus délicate dans des applications métier. La dimension métier introduit nécessairement à la fois des approches et pratiques spécifiques sur le plan de la manipulation et du traitement de l’information, mais également des vocabulaires et formes de représentation particulières. Il s’agit alors dans la conception et le développement des interfaces de s’appuyer sur des « structures sémiotiques connues » [7] pour faciliter l’appropriation de l’interface par les futurs utilisateurs.

Ce point appuie le fait que « la définition du système sémiotique nécessite une analyse indépendante des moyens informatiques » [7]. Il semble ainsi « nécessaire de définir des concepts sémiotiques indépendants des objets informatiques qui permettront à l'analyste de définir le système qui lui semble le plus adapté à ses besoins » [7]. L’indépendance qui est préconisée ici doit permettre de mieux identifier et qualifier les éléments constituants le message que va véhiculer l’interface. A partir de là, la mise en relation des concepts sémiotiques avec les objets informatiques constituera le niveau métalinguistique de l’interface. L’approche proposée dans [7] est alors de « rapprocher un " modèle conceptuel de résolution de problème " d'un " modèle du système sémiologique adapté au problème à résoudre " pour arriver à un modèle conceptuel synoptique ». Les auteurs s’intéressent ici au développement de représentation synoptique pour la supervision de réseaux de télécommunication. Cette approche de la conception d’interface peut être rapprochée de l’approche MVC, mais se centre plus sur une vue linguistique. Ainsi, le niveau métalinguistique défini constitue une réelle légende de l’interface. Le lien entre les données (objets informatiques) et leur représentation (système sémiologique) n’est plus noyé dans l’implémentation, ce qui auparavant le rendait tacite pour des non initiés. Il est alors possible d’imaginer que la malléabilité de l’interface ne soit plus réduite aux concepteurs en rendant disponible et modifiable cette couche métalinguistique (modèle conceptuel synoptique). Cette idée reste toutefois encore difficile à réellement mettre en œuvre avec les environnements de développement actuels. On reste souvent tributaire des concepteurs d’interface. Toutefois, il est possible de leur proposer certaines recommandations dans le cadre d’une ingénierie sémiotique. En voici deux exemple issues de [21] :

- « Designers should avoid using invented interface signs; »

- « Designers should select interface token sign systems from culturally established type systems of communication; »

La première recommandation évoque l’importance d’éviter à chaque nouvelle interface de mettre en œuvre des signes différents pour des fonctions identiques. Il s’agit de s’attacher une continuité dans le développement des interfaces afin d’en faciliter l’appropriation. Ceci renvoie à l’importance de conserver une homogénéité dans les systèmes sémiotiques mis en œuvre que nous avons évoqués précédemment.

La seconde recommandation spécifie l’importance de s’appuyer sur des structures sémiotiques connues. Il s’agit de prendre en compte la dimension culturelle dans le développement d’interface et donc de s’appuyer sur les langages, les formes de représentation propres aux métiers, aux domaines des utilisateurs lorsque cela est possible et lorsque de tels codes existent.

Ces recommandations sont empreintes de la philosophie sémiotique évoquant largement la problématique du signe et donc une vue linguistique de l’interface. Ainsi, en tenant compte des acteurs qui gravitent autour de l’interface, s’agissant tout aussi bien de ces concepteurs que de ces utilisateurs, elle peut être présentée comme « a one way message sent from the designer to the user, conveyed through a computer media. The system’s interface is a message that can also exchange message with the user ; hence it is a metacommunication artifact » [19]. L’interface n’est plus ici présentée comme un dispositif permettant de manipuler les données, mais comme un message entre les concepteurs et les utilisateurs. Ainsi, chaque élément constituant l’interface véhicule une sémantique et une intention définie par les concepteurs à destination des utilisateurs. Ces utilisateurs doivent alors être en mesure d’interpréter correctement le message proposé : l’interface est alors vué comme une métacommunication.

L’interaction homme machine vue comme une meta communication

Selon Paul Dourish « human computer interaction can be thought of as a form of a mediated communication between the end user and the system designer » [22]. Ce positionnement qui s’ancre dans le domaine du CSCW et du Social Computing est tout à fait en accord avec la vue linguistique de l’interaction homme machine mettant en avant l’enjeu crucial de bien définir le niveau sémiotique de l’interface.

Cette manière d’appréhender l’interaction homme machine est également partagée dans le domaine de l’ingénierie éducative où l’on peut voir apparaître la notion d’intermédiation dans le développement des systèmes interactifs [8]. L’intermédiation met l’accent sur le fait qu’une séparation entre les utilisateurs et les concepteurs n’est pas une bonne solution. Il s’agit donc d’intégrer dans le processus de conception et de déploiement des interfaces « une intermédiation (un passage plus qu’une séparation) entre les concepteurs et les usagers » [8]. Dans la conception, l’intermédiation se positionne « entre les besoins, compétences, désirs... des usagers et les contraintes, technologiques ou autre, les compétences et les désirs des concepteurs. Le système est une inscription dans la technologie qui traduit l’équilibre local, temporaire, négocié, fragile entre les parties ; » [8]. Dans le déploiement, l’intermédiation se place « entre les deux parties, usagers et concepteurs, pour en assurer la maintenance et l’évolution dans la durée. » [8].

Cette notion d’intermédiation au niveau de la conception et du déploiement met l’accent sur un aspect particulier du développement d’interface par rapport au développement des parties de systèmes informatiques plus centrées sur la manipulation de données et pas en relation avec l’utilisateur. Dans ce dernier cas, un exemple pouvant être le développement d’une base de données, il s’agit pour le concepteur de recenser les données à gérer dans le problème qu’il traite pour ensuite concevoir un modèle relationnel, qu’il implémentera au sein d’un système de gestion de bases de données. Cette tâche peut introduire une séparation assez forte entre les concepteurs et les utilisateurs. Par contre, dans le cas de l’interface homme machine constitue la partie visible et manipulable d’un système informatique, elle constitue l’outil que l’utilisateur transformera en instrument au sens de Rabardel en développant ses propres stratégies d’utilisation (notion de Shèmes d’utilisation) et de mise en œuvre (Béguin et Rabardel 2000). Il est alors admis que l’outil va transformer la tâche rendant la définition des IHM très indéterministe. De là, les démarches de conception, trop prédictives et centrées sur l’analyse de la tâche pâtissent du fait de vouloir définir à priori une activité qui va se modifier. Ceci met en avant l’importance de travailler sur des cycles courts de conception qui, en fait, remettent sensiblement en cause la dichotomie entre conception et déploiement. Des approches telles que l’ingénierie concourante, la conception participative [23] ou encore l’extreme programming [24], centrées sur une implication et collaboration des utilisateurs avec les concepteurs, semblent alors beaucoup plus adaptées.

Dans cette ordre d’idée, Kaptelinin évoque : « Perhaps a better understanding of differences between users and designers, between design for use and design in use, may help develop more pratical versions of participatory design » (Kaptelinin 2003). Cette citation introduit la variabilité de point de vue au regard de l’interface à produire. Le concepteur est majoritairement positionné sur une conception et un développement largement influencés par les structures de données mise en œuvre ainsi que la tâche qu’il a pu identifier : c’est le design for use guidé par l’utilité, l’interface devant permettre l’atteinte de buts identifiés [25]. L’utilisateur, lui, est plus sensible à l’utilisabilité et donc au design in use. Il s’agit pour lui que l’interface ne réponde pas seulement à des buts, mais introduise également une certaine ergonomie, un certain confort dans son utilisation. De plus, il s’agit qu’elle s’intègre bien à son activité métier, sa pratique. C’est bien évidemment un compromis entre les deux points de vue, qu’il faut réussir à trouver, qui passe nécessairement par une compréhension entre concepteurs et utilisateurs. Les concepteurs doivent mieux comprendre l’activité des utilisateurs, alors que ces derniers doivent faire l’effort d’appréhender les contraintes des concepteurs, par exemple conceptuelles et techniques (ex : unicité, repérage, typage et cohérence en base de données) afin que leurs informations soient correctement gérées.

Cette compréhension évoquée dans le processus de conception doit également être prise en compte lorsque l’interface est utilisée, nous renvoyant à l’importance de la vue linguistique de cette interface. En effet, « il est clair que dans la plupart des approches ou méthodes de développement classiques des IHM, l’usager est laissé livré à lui-même pour tout ce qui suit la phase de tests et de déploiement (Wild, Macredie, 2000). » [8]. Les interfaces sont alors plus ou moins acceptées, plus ou moins comprises selon qu’elle sont faciles à comprendre, ou encore selon qu’elles sont affordantes. La notion d’afordance (Gibson 1977; Gibson 1979) est issue de la psychologie de la perception. Ainsi, « Le concept d'affordance a été inventé par le psychologue de la perception Gibson [1,2] pour désigner les propriétés actionnables entre le monde et un individu (personne ou animal) » (Norman 1999). Cette notion d’affordance est en fait issue de théorie écologique faisant référence aux animaux qui s’adaptent à leur milieu. Dans la conception d’un artefact ou d’une interface, une affordance peut être liée au fait que « l'apparence du dispositif pouvait fournir les indices critiques requis pour une utilisation appropriée » (Norman 1999). Par exemple, ceci se matérialisera par l’intégration dans un dispositif technique, tel qu’une poignet, de rainures ou d’encoches matérialisant la position des doigts. Il semble que « le concept d'affordance a été adopté par la communauté des concepteurs, et tout particulièrement dans le domaine de la conception graphique et industrielle » (Norman 1999). Mais force est de constater que « le designer se préoccupe plus que les actions que l'utilisateur perçoit soient possibles plutôt que réelles » (Norman 1999).

En fait, dans le domaine de la visualisation sur écran, mettre en place des affordances réelles et physique, comme dans l’exemple de la poignée, se révèle difficile en dehors de dispositif interactifs matériels en complément de la visualisation. Il s’agira de se limiter aux affordances perçues, renvoyant à la définition et la mise en place de contraintes et de conventions. Les conventions culturelles jouent notamment un rôle majeur au niveau de l’écran (Norman 1999). La mise ne place de conventions, surtout dans la forme de représentation des informations, nous renvoie à la fois à la dimension sémiotique de l’IHM ainsi qu’à l’importance de les considérer comme une forme de communication médiatisée véhiculant un message entre concepteurs et utilisateurs. Ainsi, « User Interfaces are metacommunications artifacts. They are designed to convey a message from system designer to system user whose meaning is the answer to two fundamental questions: (1) "What kinds of problems is this application prepared to solve?" and (2) "How can these problems be solved?". (Oliveira Prates et al. 1997). Le message que l’interface doit permettre de percevoir, tel qu’il est présenté ici, tient à deux aspects :

- A quel type de problème cette interface est elle adaptée ?

- Comment le problème peut-il être résolu ?

Ces deux questions renvoient à un contexte où l’interface permet d’accompagner la résolution de problème. Dans un cadre plus élargi, notamment des interfaces de diffusion et de communication d’informations, il s’agira que le système sémiotique inhérent à l’interface soient aisément identifiable. Dans cette direction, « il est donc nécessaire que le système interactif initialement développé puisse servir lui-même comme un pont entre les deux parties au travers de l’artefact lui-même. Cela implique que […] le SIE doit contenir sa propre représentation (un méta-modèle) » [8]. Ce passage évoque la notion de « méta modèle » du système interactif (SIE : Système Interactif Evolutif). Le méta modèle doit constituer un contrat de lecture sur l’interface, le langage qu’elle définit, permettant de la percevoir de manière monosémique. Sa mise à disposition auprès de l’utilisateur doit accompagner l’utilisateur dans l’exploitation de cette interface. On pourra alors considérer que ce méta modèle est appréhendable naturellement, si, par exemple, l’interface s’appuie sur une codification ou des conventions acceptées et connues par les utilisateurs. En dehors de cette situation, il s’agira de le préciser sous la forme d’une légende ou d’une documentation disponible in vivo.

Interface homme information

Nous avons évoqué au début de ce chapitre la notion d’interaction homme informations qui se focalise sur la mise en relation entre l’utilisateur et des données abstraites contenues en mémoire. En considérant l’interaction homme machine comme une métacommunication, nous proposons de dissocier deux types d’interface homme information :

- Les interfaces de lecture

- Les interfaces auteur

Les interfaces de lecture se focalisent sur la diffusion du message entre les concepteurs et les utilisateurs de l’interface. Dans la conception de ces interfaces, il s’agit de s’attacher aux modalités de communication des informations, que cela soit dans le choix du medium, du signe et de la forme. L’interface est adaptée, et souvent spécifique, au message et n’offre qu’une malléabilité limitée au travers de comportements dynamiques et interactifs. La modification ou l’adaptation du message transmis doit passer par les concepteurs.

Les interfaces auteur se différencient par le fait qu’elles vont permettre la communication d’un contenu, mais également l’édition du contenu. Il pourra s’agir ou d’interfaces permettant de construire un message à partir de moyens de mis en forme de texte ou de graphique. Il pourra également s’agir d’une interface de diffusion de contenu, comme évoqué précédemment, mais permettant une contextualisation du contenu par l’utilisateur. Dans ce dernier cas, « le contenu [véhiculé par l’interface] cesse d’être un objet indépendant du récepteur et immuable, pour devenir une matière à recomposer, comme le sont les cours en salles que chacun doit suivre, synthétiser et revoir selon sa compréhension et ses priorités » [26]. Ainsi, Dufresne précise « que l’environnement doit être malléable car il ne peut être défini a priori. Les interfaces pourraient ainsi être conçues comme des outils supportant directement l’activité et non plus uniquement comme des intermédiaires entre des outils, des services et des utilisateurs » [27].

Ce positionnement peut amener à considérer les interfaces comme des documents et à les construire comme tels. L’interface comme nous l’appréhendons constitue un medium de communication véhiculant un message (un signe) entre concepteur et utilisateur avec une présentation (une forme) particulière. En ce sens, l’interface peut être rapprochée de la notion de document réunissant ces trois dimensions. Elle se différencie en général du fait que les données en dehors de la perception sont dissociées de la présentation, contrairement à un document dont les données sont intégrées à la présentation, ce qui en fait un objet persistant (Beaudoux 2004) et autoportant. Le document conserve son état et doit être éditable pour une grande part sans être en relation avec un système. Ainsi, Beaudoux (Beaudoux 2004) affirme qu’il est « inutile de posséder une application spécifique pour le lire » . Ce dernier point est difficile à atteindre dans son intégralité puisque l’on est souvent confronté à des difficultés de compatibilité entre format dans le monde numérique.

La problématique de construction du message n’est pas simple si l’on tient compte en particulier de la dimension sémiotique de l’interface que nous avons discuté. Il s’agit de bien prendre en compte ces spécificités et de ne pas uniquement se limiter à une analyse des besoins où l’utilisateur se positionne essentiellement en source d’information : l’utilisateur doit se révéler une source d’inspiration dans la conception de l’interface et la définition des modalités du message qu’elle véhicule.

Le message véhiculé par l’interface est essentiellement lié à la perception directe et sémantique de la visualisation proposée à l’utilisateur. La perception directe renvoie à la forme de visualisation d’information : la présentation (Beaudoux 2004). La perception sémantique correspond « aux données qui sont interprétées par l’utilisateur via la présentation » (Beaudoux 2004). C’est toute l’importance de la forme de visualisation, que nous allons aborder dans le chapitre suivant.

[1] L’utilisabilité est à différencier de l’utilité qui correspond au respect de l’atteinte du but. Les critères d’utilisabilité sont la facilité d’apprentissage et d’utilisation, l’efficacité d’utilisation, la facilité de mémorisation, l’utilisation sans erreurs, la documentation, la satisfaction [28]

Références

- ↑ 1,0 et 1,1 Trésor de la langue française informatisé - http://atilf.atilf.fr/tlf.htm

- ↑ Coutaz et Ménadier cité dans Zacklad, M., N. Legay et J. Blanquet (1996). La modélisation conceptuelle des IHM avec PSS. actes du 5ème Colloque Ergo-IA: 101-115

- ↑ 3,0 3,1 3,2 et 3,3 Kovacs, B., F. Gaunet et X. Briffault (2004). Les techniques d'analyse de l'activité pour l'IHM, Hermès Science.

- ↑ Nanard dans Zacklad, M., N. Legay et J. Blanquet (1996). La modélisation conceptuelle des IHM avec PSS. actes du 5ème Colloque Ergo-IA: 101-115

- ↑ 5,0 et 5,1 Nanard, J. (1990). La manipulation directe en interface homme-machine. Montpellier, Montpellier II.

- ↑ (Béguin et Rabardel 2000)

- ↑ 7,0 7,1 7,2 7,3 7,4 7,5 et 7,6 Zacklad, M., N. Legay et J. Blanquet (1996). La modélisation conceptuelle des IHM avec PSS. actes du 5ème Colloque Ergo-IA: 101-115

- ↑ 8,0 8,1 8,2 8,3 8,4 8,5 8,6 8,7 8,8 et 8,9 Bourguin, G., A. Derycke et J. C. Tarby (2005). "Systèmes Interactifs en Co évolution Réflexions sur les Apports de la Théorie de l'Activité au support des pratiques Collectives Distribuées." RIHM 6(1).

- ↑ http://www.labo-sun.com/resource-FR-articles-596-0-java-j2ee-introduction-a-j2ee.htm

- ↑ Chateauraynaud, F. (2003). "Marlowe. Vers un générateur d’expériences de pensée sur des dossiers complexes." Bulletin de Méthodologie Sociologique(79): 5-46

- ↑ 11,0 et 11,1 Nicolle, A. et V. S. Dizier (1999). Vers un modèle des interactions langagières. L'interdisciplinaire. Lyon.

- ↑ 12,0 et 12,1 Nicolle, A. et V. S. Dizier (1999). Vers un modèle des interactions langagières. L'interdisciplinaire. Lyon.

- ↑ Baker, M., E. d. Vries, K. Lund et M. Quignard (2001). Interactions épistémiques médiatisées par ordinateur pour l'apprentissage des sciences : bilan de recherches. Actes du colloque Environnements Interactifs d'Apprentissage avec Ordinateur. 8.

- ↑ Searle., J. (1972). Les actes de langage, Essai de philosophie du langage., Hermann.

- ↑ Searle, J. R. et D. Vanderveken (1985). Foundations of Illocutionary Logic. Cambridge, Cambridge University Press.

- ↑ Boullier, D. (2001). "Les choix techniques sont des choix pédagogiques : les dimensions multiples d'une expérience de formation à distance." Sciences et Techniques Educatives.

- ↑ Bateson, G. et Y. Winkin (1984). La nouvelle communication, Seuil.

- ↑ http://www.labo-sun.com/resource-FR-articles-596-0-java-j2ee-introduction-a-j2ee.htm

- ↑ 19,0 et 19,1 Oliveira Prates, R., C. S. De Souza et A. Cristina Bicharra Garcia (1997). "A semiotic framework for multi-user interfaces." SIGCHI 29(2).

- ↑ Enjalbert, P. (1996). "De l'interprétation (sens,structure et processus)." Intelecta.

- ↑ 21,0 21,1 21,2 et 21,3 Souza, C. S. d. (1996). The Semiotic Engineering of Concreteness and Abstractness: From User Interface Languages To End User Programming Languages.

- ↑ Dourish, P. (1999). Where the action is - The Foundations of Embodied Interaction, MIT Press.

- ↑ O'Neill, E. (2001). User-Developer Cooperation in Software Development - Building Common Ground and Usable Systems. London.

- ↑ Casabianca, M. (2005). Extreme Programming O'Reilly.

- ↑ Erreur de référence : Balise

<ref>incorrecte : aucun texte n’a été fourni pour les références nomméeskovacs2004 - ↑ Dufresne, A. (1997). "Conception d'interfaces pour l'apprentissage à distance." La revue de l'éducation à distance 12: 177-200.

- ↑ Dufresne, A. (2001). "Conception d'une interface adaptée aux activités de l'éducation \`a distance - ExploraGraph." Sciences et Techniques Educatives.

- ↑ Kovacs, B., F. Gaunet et X. Briffault (2004). Les techniques d'analyse de l'activité pour l'IHM, Hermès Science.