Différences entre les versions de « Moteur de Recherche »

m |

m (→Google) |

||

| (7 versions intermédiaires par le même utilisateur non affichées) | |||

| Ligne 1 : | Ligne 1 : | ||

[[ | == Définition == | ||

[[Fichier:Comment_fonctionne_un_moteur_de_recherche_.png|droite|723x723px]] | |||

[[Fichier:Crawler-smile.jpg|Crawler|vignette]] | |||

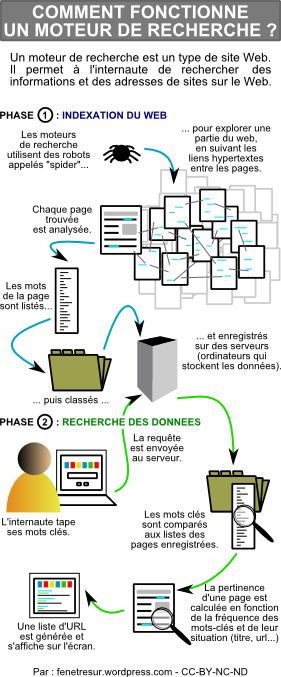

Un moteur de recherche est un programme informatique conçu pour rechercher des informations sur le World Wide Web. Son principal objectif est d'aider les utilisateurs à trouver des données pertinentes en réponse à leurs requêtes. Les moteurs de recherche parcourent et indexent des milliards de pages web, puis fournissent des résultats de recherche basés sur la pertinence de ces pages par rapport à la requête de l'utilisateur. | |||

Le processus de fonctionnement d'un moteur de recherche se divise généralement en trois étapes : | |||

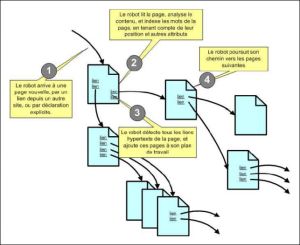

# '''Exploration (Crawling) :''' Des robots, également appelés "spiders" ou "crawlers", parcourent le web en suivant les liens entre les pages. Ils collectent des informations sur le contenu de chaque page qu'ils visitent. | |||

# '''Indexation :''' Les informations collectées sont ensuite indexées et organisées dans une base de données. L'index permet au moteur de recherche de trouver rapidement les pages pertinentes lorsqu'un utilisateur effectue une recherche. | |||

# '''Recherche :''' Lorsqu'un utilisateur saisit une requête dans la barre de recherche, le moteur de recherche utilise son index pour trouver les pages les plus pertinentes en fonction de la requête. Les résultats de la recherche sont généralement présentés par ordre de pertinence. | |||

Google, Bing et Yahoo! sont parmi les moteurs de recherche les plus populaires, mais il en existe de nombreux autres, chacun avec ses propres algorithmes et méthodes de classement des résultats. | |||

== Processus d'un moteur de recherche == | |||

approfondissons davantage chaque étape du processus d'un moteur de recherche : | |||

# '''Exploration (Crawling) :''' | |||

#* Les robots d'exploration, souvent appelés "spiders" ou "crawlers", sont des programmes automatisés qui parcourent le web de manière systématique. | |||

#* Ils débutent leur exploration en visitant quelques pages web connues, puis suivent les liens présents sur ces pages pour découvrir de nouvelles pages. | |||

#* Les robots d'exploration analysent le contenu textuel des pages, extraient les liens, les mots-clés, et d'autres informations utiles. | |||

# '''Indexation :''' | |||

#* Les informations collectées par les robots d'exploration sont ensuite organisées dans une base de données appelée "index". | |||

#* L'index est une sorte de répertoire qui permet au moteur de recherche de localiser rapidement les pages pertinentes en fonction des termes de recherche. | |||

#* L'indexation peut impliquer une analyse approfondie du contenu de la page, de la structure des liens et d'autres facteurs. | |||

# '''Recherche :''' | |||

#* Lorsqu'un utilisateur saisit une requête dans la barre de recherche, le moteur de recherche examine son index pour trouver des pages qui correspondent le mieux à la requête. | |||

#* Les moteurs de recherche utilisent des algorithmes complexes pour évaluer la pertinence des pages en fonction de divers critères, tels que la fréquence des mots-clés, la qualité du contenu, la structure des liens, etc. | |||

#* Les résultats de la recherche sont présentés à l'utilisateur sous forme de liste, généralement classée par ordre de pertinence estimée. | |||

Les moteurs de recherche mettent constamment à jour leurs index pour refléter les changements sur le web. Les algorithmes de recherche sont également en constante évolution pour améliorer la précision des résultats. Les entreprises de moteurs de recherche investissent massivement dans la recherche et le développement pour rester compétitives et offrir une expérience utilisateur optimale. | |||

== Les moteurs de recherche == | |||

[[Fichier:Moteur-de-recherche2.gif|alt=Les moteurs de recherche|centré|cadre|Les moteurs de recherche]] | |||

== Google == | |||

{| | |||

|<youtube>BNHR6IQJGZs</youtube> | |||

|<youtube>mTBShTwCnD4</youtube> | |||

|} | |||

== Références == | |||

Version actuelle datée du 19 novembre 2023 à 17:59

Définition

Un moteur de recherche est un programme informatique conçu pour rechercher des informations sur le World Wide Web. Son principal objectif est d'aider les utilisateurs à trouver des données pertinentes en réponse à leurs requêtes. Les moteurs de recherche parcourent et indexent des milliards de pages web, puis fournissent des résultats de recherche basés sur la pertinence de ces pages par rapport à la requête de l'utilisateur.

Le processus de fonctionnement d'un moteur de recherche se divise généralement en trois étapes :

- Exploration (Crawling) : Des robots, également appelés "spiders" ou "crawlers", parcourent le web en suivant les liens entre les pages. Ils collectent des informations sur le contenu de chaque page qu'ils visitent.

- Indexation : Les informations collectées sont ensuite indexées et organisées dans une base de données. L'index permet au moteur de recherche de trouver rapidement les pages pertinentes lorsqu'un utilisateur effectue une recherche.

- Recherche : Lorsqu'un utilisateur saisit une requête dans la barre de recherche, le moteur de recherche utilise son index pour trouver les pages les plus pertinentes en fonction de la requête. Les résultats de la recherche sont généralement présentés par ordre de pertinence.

Google, Bing et Yahoo! sont parmi les moteurs de recherche les plus populaires, mais il en existe de nombreux autres, chacun avec ses propres algorithmes et méthodes de classement des résultats.

Processus d'un moteur de recherche

approfondissons davantage chaque étape du processus d'un moteur de recherche :

- Exploration (Crawling) :

- Les robots d'exploration, souvent appelés "spiders" ou "crawlers", sont des programmes automatisés qui parcourent le web de manière systématique.

- Ils débutent leur exploration en visitant quelques pages web connues, puis suivent les liens présents sur ces pages pour découvrir de nouvelles pages.

- Les robots d'exploration analysent le contenu textuel des pages, extraient les liens, les mots-clés, et d'autres informations utiles.

- Indexation :

- Les informations collectées par les robots d'exploration sont ensuite organisées dans une base de données appelée "index".

- L'index est une sorte de répertoire qui permet au moteur de recherche de localiser rapidement les pages pertinentes en fonction des termes de recherche.

- L'indexation peut impliquer une analyse approfondie du contenu de la page, de la structure des liens et d'autres facteurs.

- Recherche :

- Lorsqu'un utilisateur saisit une requête dans la barre de recherche, le moteur de recherche examine son index pour trouver des pages qui correspondent le mieux à la requête.

- Les moteurs de recherche utilisent des algorithmes complexes pour évaluer la pertinence des pages en fonction de divers critères, tels que la fréquence des mots-clés, la qualité du contenu, la structure des liens, etc.

- Les résultats de la recherche sont présentés à l'utilisateur sous forme de liste, généralement classée par ordre de pertinence estimée.

Les moteurs de recherche mettent constamment à jour leurs index pour refléter les changements sur le web. Les algorithmes de recherche sont également en constante évolution pour améliorer la précision des résultats. Les entreprises de moteurs de recherche investissent massivement dans la recherche et le développement pour rester compétitives et offrir une expérience utilisateur optimale.